人工智能走进每一个人(2017~现在) - AI全书 -- 知识铺 -- 知识铺

环境变化

新千年之后,计算机技术得到了超前的速度发展,AI的量变到质变累积了基础。

互联网技术

随着互联网技术的出现,促进了全球范围内的知识共享和协作,使得AI领域的研究人员能够轻松分享研究成果和技术进展。开源项目和在线论坛为AI研究和应用提供了交流平台,加速了新技术的传播和应用。

同时互联网也创造了大量的数据内容,为AI提供了丰富的数据资源,从智能个人助手到自动翻译,再到推荐系统和智能家居设备,无论在电商还是社交,电子图书馆变得非常容易获取,作为人工智能和机器学习算法的训练的数据来源,

计算机硬件技术

自从戈登·摩尔(Gordon Moore)在1965年提出摩尔定律,半导体工业得到空着的发展。计算机存储和算力也随之快速提升,GPU(图形处理单元)、TPU(张量处理单元)和其他专用AI加速器的出现和性能提升,AI模型的训练速度大大加快,这些硬件专为并行处理设计,能够有效处理大规模数据集和复杂计算,从而缩短了模型训练时间,使得更为复杂和深层的神经网络模型成为可能。

软件技术

硬件技术的发展促使研究者探索新型神经网络架构,例如量子计算和神经形态计算。这些新型架构旨在模仿人脑的工作方式,以更高效地处理学习任务,而先进的硬件技术为这些探索提供了可能,软件技术在以下几方面都得到了很大的突破:

-

人工智能算法(机器学习、深度学习)

-

神经网络

-

计算机视觉

-

自然语言处理

随着这些技术的发展,已经逐渐被应用到人们日常生活中,比如:

-

门禁人脸识别

-

汽车自动驾驶

-

工业智能制造

-

智能音箱(亚马逊Echo、谷歌Assistant助手、苹果Siri助手、小爱音箱、天猫精灵、百度小度)

-

…

人工智能技术为这些应用场景解决了不少需求和问题,但是都比较偏单一和规则化,超出一定的范围,可能就变地很“弱智”,总体还是基本停留在弱人工智能阶段。

神经网络架构的变化

自然语言处理 (NLP) 是深度学习中一个颇具挑战的问题,与图像识别和计算机视觉问题不同,自然语言本身没有良好的向量或矩阵结构,且原始单词的含义也不像像素值那么确定和容易表示。一般我们需要用词嵌入技术将单词转换为向量,然后再输入计算机进行计算。

语言模型是一种基于统计学和机器学习方法的自然语言处理技术,它用于评估和预测一个给定序列的概率分布,通常是单词序列或字符序列。语言模型的主要应用是文本生成、机器翻译、语音识别等任务。

循环神经网络(RNN,Recurrent Neural Network)

人类的阅读习惯不会从头开始思考每个出现单词的含义,而是透过前面单词的信息来理解当前单词的含义。基于这种行为,循环神经网络 (RNN) 应运而生。

RNN是一种经典的序列模型,它通过循环的方式将序列中的信息逐个输入到网络中,并在网络内部使用循环结构来捕捉序列中的时间依赖关系。

RNN模型的主要问题是输入是序列,只能按照顺序处理数据,无法并行处理,计算成本很高。此外,它也会出现梯度消失的问题,因此无法处理很长的序列。

尽管也有包括GRU、LSTM 这种改进,也无法解决这些根本性的问题:即使通过注意力机制改进了记忆,计算也没有得到改进。处理过程仍然是顺序的,无法解决长文本上下文数据关系和计算效率,因为每个标记必须按顺序处理。因此,才诞生了Transformer。

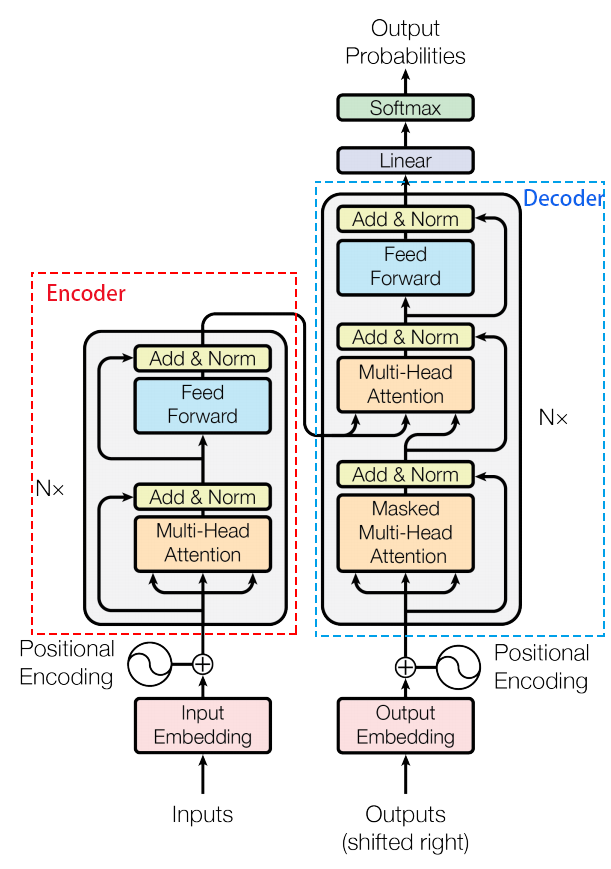

Transformer架构

2017年Google在论文《Attention is All You Need》中提出 Transformer架构。这是一种基于自注意力机制(self-attention mechanism)的神经网络架构,它通过将序列中所有位置的信息进行交互,来处理长序列。Transformer将输入序列分别传递给编码器和解器,每个部分由多个层次组成,每个层次由多头自注意力机制和全连接层组成。Transformer的编码器和解码器可以同时处理多个序列位置,因此可以更高效地处理长序列。下图是这篇论文提到的网络示意图:

Transformer架构的特点与大模型的出现

Transformer架构特点

并行处理

Transformer架构摒弃了RNN中每个处理步骤依赖于前一个步骤的串行关系,转而采用并行处理的方式。这意味着输入的语句可以作为一个整体被送入embedding层进行处理,极大地提升了计算速度,并且由于不再过分强调输入序列的次序,从而解决了长依赖的问题。

位置编码(positional encoding)

为了使模型能够理解输入元素的位置信息及其在整个输入中的相对位置,Transformer引入了位置编码技术。位置编码不仅包含了元素的位置信息,还包含了各部分(token)之间的关联关系数据,这有利于在自注意力机制中计算权重,尤其是在多头注意力机制下。

自注意力机制(self-attention mechanism)

自注意力机制是《Attention is All You Need》论文中提出的一项创新,也是Transformer架构的核心组件之一。它允许模型在不依赖时间顺序的情况下对序列中不同位置之间的依赖关系进行建模,从而更有效地处理长序列。

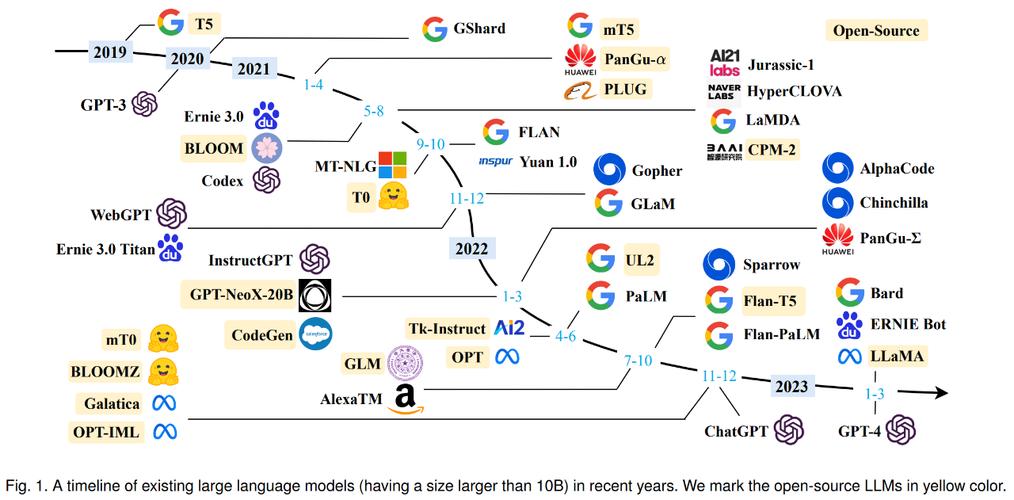

大模型的出现

Transformer架构的诞生为处理海量信息和构建具有大量参数的模型提供了可能。自从《Attention is All You Need》发表以来,Transformer及其变体已经成为训练大规模语言模型的首选架构,在大数据集上取得了广泛的应用。

自从Transformer架构的出现,大语言模型如雨后春笋般陆续涌现。aaaaaa#### 拐点纪:预训练模型的崛起aaaaaa2018年,随着谷歌发布的BERT(Bidirectional Encoder Representations from Transformers),预训练模型迎来了一个里程碑。BERT通过预先训练大规模语料库,使得模型能够理解更为复杂的语境和语义关系。这一技术创新在自动问答、机器翻译等应用中为大语言模型打开了新的可能性。aaaaaa

- 2018年06月: GPT-1,约5GB文本,1.17亿参数量;aaaaaa

- 2019年02月: GPT-2,约40GB文本,15亿参数量;aaaaaa

- 2020年6月11日: 宣布了GPT-3语言模型。aaaaaa#### 全球纪:大语言模型的跨领域应用aaaaaa在2022年秋季,GPT-3因其在社交媒体上的病毒式传播而引发了广泛关注。这款拥有超过1.75亿参数的大规模语言模型(LLMs),开启了自然语言处理(NLP)领域的新纪元。aaaaaa在这个阶段,大规模预训练模型的涌现彻底改变了NLP的研究和应用格局。大规模语言模型充分挖掘了大量未标注数据的潜力,赋予模型更强的语言理解和泛化能力。采用预训练和微调策略的大模型在多个NLP任务上实现了前所未有的成就,在模型准确性、泛化能力和复杂任务处理方面展示了出色的表现。这不仅吸引了大量投资,也催生了NLP领域全新的发展和研究方向。aaaaaa同时,随着大模型应用门槛和使用门槛的逐步降低,大量的大模型产品不断涌现——例如ChatGPT、跨语言代码编译工具Cursor、GitHub官方代码编写工具CopilotX、一键生成PPT内容的Gamma AI,Office套件中配置的Copilot、Photoshop中配置的fill features,以及广泛生成图像的MidJourney和Stable Diffusion。这些应用不仅改变了商业运营方式,也极大地影响了人们的生活和工作模式,大语言模型跨足金融、医疗、法律等多个领域,为各行各业带来了智能化和效率提升。aaaaaa## 多模态出现

随着大语言模型的广泛应用,多模态学习也成为了大语言模型发展的新方向,模型能够更好地理解文字、图像、声音等多种信息形式。同时,自适应学习的理念也引领着大语言模型更好地适应不同领域和任务,使其更具泛化能力。2月16日凌晨,OpenAI再次震撼全球科技界,发布了名为Sora的文生视频模型,Sora相比此前其他文生视频模型,已经跨越到实用生产力工具,不仅标志着人工智能在视频生成领域的重大突破,更引发了关于人工智能发展对人类未来影响的深刻思考。同一天谷歌推出Gemini 1.5 Pro,支持长达100万个token,远超当前其他基础模型,可以一次性处理大量信息,如1小时的视频、11小时的音频、超过3万行代码或超过70万个单词,Gemini 1.5 Pro是一个中型大小的多模态模型。随着Sora的发布,人工智能似乎正式踏入了通用人工智能(AGI)的时代。AGI是指能够像人类一样进行各种智能活动的机器智能,包括理解语言、识别图像、进行复杂推理等。Sora模型能够直接输出长达60秒的视频,并且视频中包含了高度细致的背景、复杂的多角度镜头,以及富有情感的多个角色。这种能力已经超越了简单的图像或文本生成,开始触及到视频这一更加复杂和动态的媒介。这意味着人工智能不仅在处理静态信息上越来越强大,而且在动态内容的创造上也展现出了惊人的潜力。人类自古以来就有着将梦境变成现实的渴望,而Sora的推出无疑让这个进程向前迈进了一大步。通过高度逼真的视频生成,Sora让我们看到了梦境与现实交融的可能性。未来的艺术家、导演甚至普通人,都可以借助Sora这样的工具,将自己的创意和想象迅速转化为视觉作品。这不仅将极大地丰富我们的文化生活和娱乐体验,也可能对影视、广告等产业产生颠覆性的影响。Sora的发布还带来了另一个令人震撼的启示:用AI生成AI的时代或许已经不再遥远。在AI技术的推动下,像Sora这样的模型不仅可以模仿人类的创作风格,甚至有可能自我进化,产生全新的艺术风格和创作方式。这种“AI生成AI”的过程将使人工智能的发展变得更加不可预测,但同时也充满了无限的可能性。AI时代的来临,不仅将推动人类从碳基生命走向硅基生命,还将对人类的生产力和生活方式产生深远影响。在硅基生命的视角下,人类或许可以通过与AI的深度融合,实现生产力的飞跃,创造前所未有的文明高度。然而,这也带来了前所未有的挑战和伦理问题。当AI生成的内容越来越逼真,人类将很难区分梦幻和现实,这可能会对我们的认知、情感甚至社会稳定产生深刻影响。

人工智能的影响是直接影响着现代文明的发展,人工智能已成为未来已来的标志,将在当下和今后继续走近和影响人们的生活,并对人类社会进步产生广泛而深刻的影响。从自动驾驶汽车到智能家居系统,从虚拟购物助手到医疗诊断系统,AI正逐渐渗透到我们生活的方方面面。

AI可以解放人力,提高工作效率,AI数字人、AIGC(内容生成),改变着身边的多个行业,如新闻媒体、电商营销、策划、产品设计、影视制作等等,一系列繁重、重复、甚至危险的任务都逐渐会被AI替换掉,就业岗位会被一些AI从事职业给替换掉,比如提示词工程师;

第一批因AI失业的人已经来了,我们无力去阻止科技的快速发展,只能去拥抱和迎接未来到到来,作为人类历史上的见证者和参与者,我们必须提升自己的相关AI认识和技术,去学习它、使用它、甚至改进它。

虽然AI技术带来了许多好处,但也存在一些担忧和风险。例如,AI技术可能导致失业率上升、隐私泄露、数据滥用和道德问题等。

- 原文作者:知识铺

- 原文链接:https://index.zshipu.com/ai/post/20241218/%E4%BA%BA%E5%B7%A5%E6%99%BA%E8%83%BD%E8%B5%B0%E8%BF%9B%E6%AF%8F%E4%B8%80%E4%B8%AA%E4%BA%BA2017~%E7%8E%B0%E5%9C%A8-AI%E5%85%A8%E4%B9%A6--%E7%9F%A5%E8%AF%86%E9%93%BA--%E7%9F%A5%E8%AF%86%E9%93%BA/

- 版权声明:本作品采用知识共享署名-非商业性使用-禁止演绎 4.0 国际许可协议进行许可,非商业转载请注明出处(作者,原文链接),商业转载请联系作者获得授权。

- 免责声明:本页面内容均来源于站内编辑发布,部分信息来源互联网,并不意味着本站赞同其观点或者证实其内容的真实性,如涉及版权等问题,请立即联系客服进行更改或删除,保证您的合法权益。转载请注明来源,欢迎对文章中的引用来源进行考证,欢迎指出任何有错误或不够清晰的表达。也可以邮件至 sblig@126.com