利用智能使用人工智能:深入了解提示工程 --知识铺

提示工程

[

](https://.com/@researchgraph?source=post_page—–21112dbfc789——————————–)

利用智能使用人工智能:深入了解提示工程

图片来自 Unsplash。

作者

- 德鲁夫·古普塔(兰花:0009-0004-7109-5403)

介绍

大型语言模型(LLMs)已成为自然语言处理(NLP)领域的新常态。凭借其改进的性能和生成能力,世界各地的人们都依赖它来完成各种任务。

然而,事实证明,它们有时会产生不正确的答案。然而,它的机会可以通过一种称为提示工程的技术来减少。在本文中,我们将详细讨论什么是提示工程以及可以使用的一些技术。

然而,在深入研究提示工程之前,我们必须了解工作和执行方式LLMs。在后端,LLMs它作为一个文本生成工具,使用概率计算器一个接一个地预测单词。

对于 ChatGPT 和其他生成式 AI 模型,LLMs尝试将用户输入与领域数据(训练数据)进行映射。映射数据后,将生成输出。因此,当用户输入新的输入时,LLMs会产生幻觉,从而产生荒谬的输出。

为了充分利用其LLMs潜力,我们需要了解如何将这些映射转换为域映射。这正是提示工程的意义所在。

什么是提示工程?

提示工程可以定义为通过给出一组关于所需输出的明确指令来LLM生成所需的输出。提示工程有助于更好地了解 LLMs的功能和局限性。这种方法不仅仅是设计和开发提示。

它包括交互、开发和测试所需的LLMs各种技能和技术。

带有一些说明的简单提示可以为您提供输出,但是,要获得高质量的结果,必须精心设计提示。提示可以包含诸如问题和其他详细信息之类的说明,这些说明提供了更多上下文,例如提供有关答案的提示。

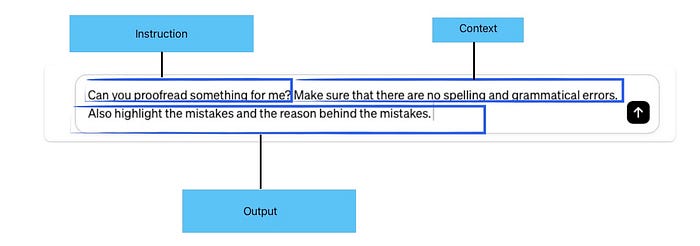

提示的元素

提示可以包含以下任何元素:

- 指令:用户希望模型执行的任何特定任务

- 上下文:模型可用于生成所需输出的其他信息

- 输入数据:需要回答的输入或问题

- 输出指示灯:输出的格式

ChatGPT 中给出的提示示例。它包含所需输出的指令,上下文和格式。

提示工程技术

根据手头的任务,有几种提示工程技术。

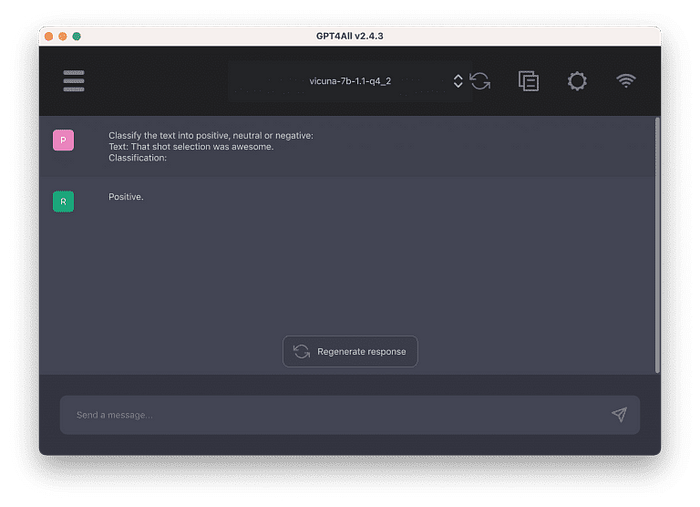

- 零样本提示:在零样本提示的情况下,为模型提供一个提示,该提示不是训练数据的一部分,并且需要执行某些任务。但是,当零样本提示不起作用时,将使用少量样本提示。

零样本提示示例。来源:https://machinelearningmastery.com/what-are-zero-shot-prompting-and-few-shot-prompting/

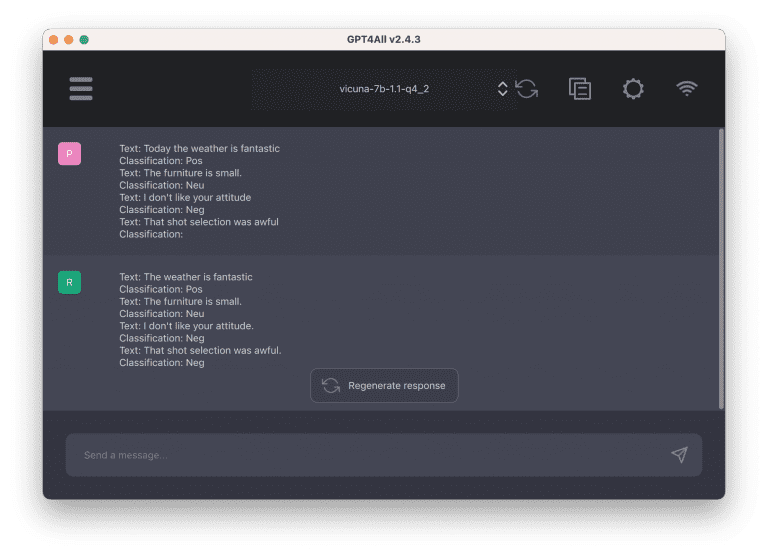

- 小样本提示:在小样本提示的情况下,模型在提示中被给出各种演示或示例,并期望通过这些演示或示例进行学习,然后产生输出。

小样本提示示例。来源:https://machinelearningmastery.com/what-are-zero-shot-prompting-and-few-shot-prompting/

-

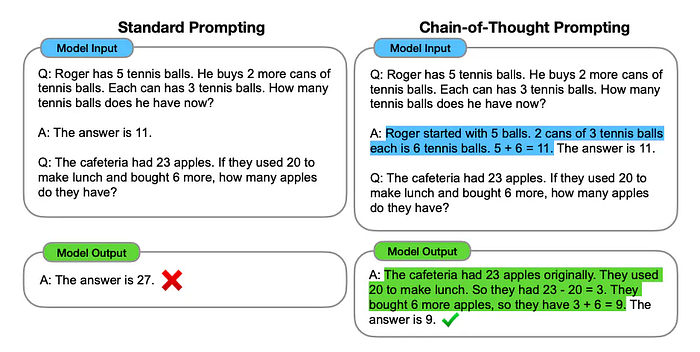

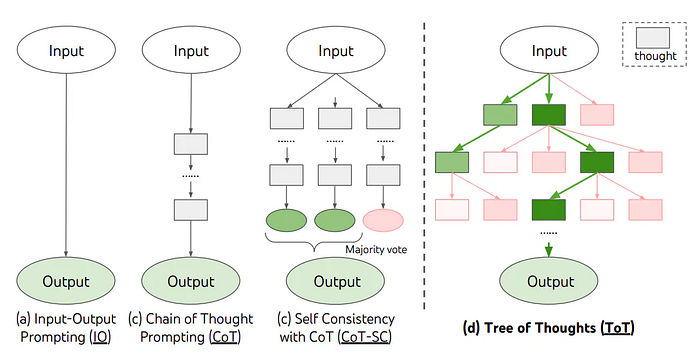

思维链 (CoT) 提示:它使LLM用户能够通过中间步骤为用户提供复杂的推理。CoT 可以与小样本提示相结合,以允许LLM学习推理并生成所需的输出。

除了零样本和少样本之外,自动思维链(Auto-CoT)也是另一个过程。这种提示技术使用让我们思考的分步技术LLM,然后为答案生成演示。

CoT 提示示例。来源:https://www.promptingguide.ai/techniques/cot

-

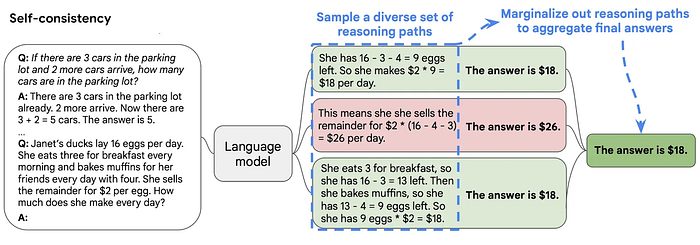

自洽提示:这种提示技术背后的想法是通过少量 CoT 对多个不同的推理问题进行采样。它允许LLM打破和理解提示中提出的不同问题背后的原因。

它提高了生成的答案和解释的准确性。

自洽提示示例。来源:https://learnprompting.org/docs/intermediate/self_consistency

-

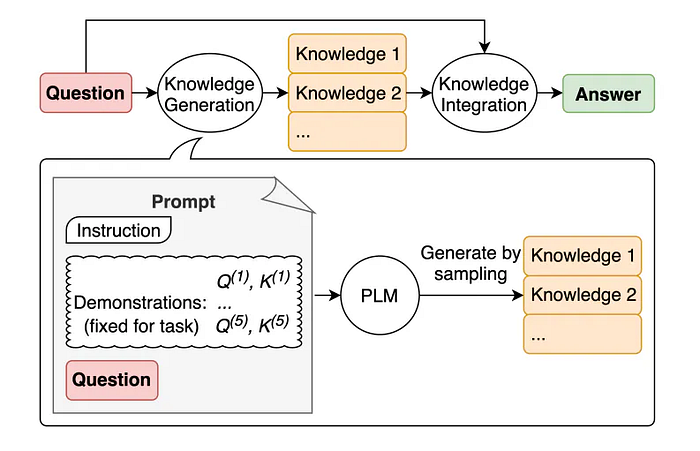

生成的知识提示:在这种提示技术中,用户要求LLM生成有关特定主题的一些知识,然后用于生成更多内容。例如:如果你必须写一篇关于板球的博客。

在要求写博客之前,LLM您首先要求LLM陈述有关板球的一些事实。由此产生的知识LLM可用于帮助它编写更好的博客。

常识提示示例。来源:https://www.promptingguide.ai/techniques/knowledge

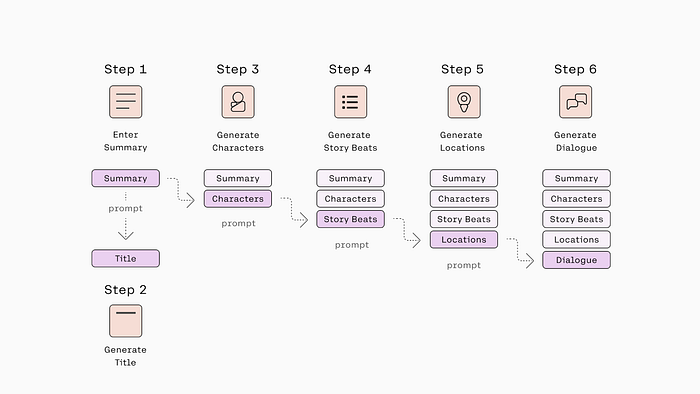

- 提示链接:在此技术中,提示被分解为一组较小的子提示。生成的响应将与下一个提示一起提供。它有助于将一个大问题分解成LLM可能难以解决的小子问题。

提示链接的示例。来源:https://txt.cohere.com/chaining-prompts/

- 思想(ToT)之树提示:这种技术建立在思想之树框架之上,也使用完善的思想链框架。它允许通过LLM创建各种知识块来展示卓越的推理能力。

思想之树提示的例子。来源:https://www.promptingguide.ai/techniques/tot

-

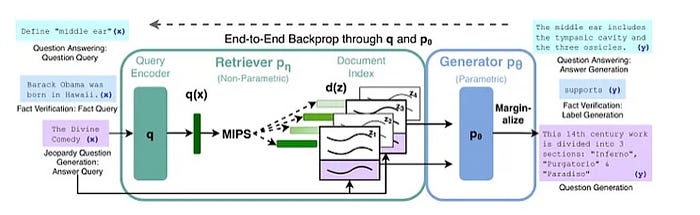

检索增强生成 (RAG):此技术使用由大量数据LLM支持的数据。通过提供LLM相关的上下文,我们允许模型从数据集中检索所需的知识。

在RAG的情况下,它LLM增加了一个大型数据语料库和一个检索器系统,该系统可以获取查询所需的答案。

原始 RAG 模型的示意图。资料来源:Lewis, P., Perez, E., Piktus, A., Petroni, F., Karpukhin, V., Goyal, N., Küttler, H., Lewis, M., Yih, W., Rocktäschel, T., Riedel, S., & Kiela, D. (2020).Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks,链接:https://doi.org/10.48550/arXiv.2005.11401

这些技术只是冰山一角。可以使用其他技术,如自动提示、主动提示、定向刺激等。

尽管提示工程有助于利用 LLM的潜力,但应遵循某些经验法则。

其中包括将指令放在提示的开头,提供有关所需输出的详尽而具体的信息,从零样本开始,然后转向小样本提示,并强调该做什么而不是不该做什么。

结论

LLMs已成为用户中流行的工具。然而,人们仍然无法充分利用它的潜力。提示工程允许用户以这样一种方式定制他们的输入命令,LLMs以便可以产生更好的响应。

通过这样做,用户和LLMs用户都可以互相帮助。

引用

- 刘易斯,P.,佩雷斯,E.,皮克图斯,A.,彼得罗尼,F.,卡尔普欣,V.,戈亚尔,N.,库特勒,H.,刘易斯,M.,Yih,W.,Rocktäschel,T.,Riedel,S.和Kiela,D.(2020)。知识密集型 NLP 任务的检索增强生成(第 4 版)。arXiv的。https://doi.org/10.48550/ARXIV.2005.11401

- 学习提示:与 AI 通信的指南。(无日期)。适用于: https://learnprompting.org/docs/intermediate/self_consistency

- 提示工程指南 — Nextra。(无日期)。www.promptingguide.ai. 可在以下位置获得: https://www.promptingguide.ai/

- 使用 OpenAI API 进行提示工程的最佳实践(无日期)。可在: https://help.openai.com/en/articles/6654000-best-practices-for-prompt-engineering-with-the-openai-api

- 命令模型的链接提示。(2023). Cohere 的背景.适用于: https://txt.cohere.com/chaining-prompts/

- 赫尔伯特,D.(2023 年)。使用思想之树提示来增强 ChatGPT 的推理能力。GitHub的。可在: https://github.com/dave1010/tree-of-thought-prompting

- 原文作者:知识铺

- 原文链接:https://index.zshipu.com/gpt/post/202403/prompt/%E5%88%A9%E7%94%A8%E6%99%BA%E8%83%BD%E4%BD%BF%E7%94%A8%E4%BA%BA%E5%B7%A5%E6%99%BA%E8%83%BD%E6%B7%B1%E5%85%A5%E4%BA%86%E8%A7%A3%E6%8F%90%E7%A4%BA%E5%B7%A5%E7%A8%8B--%E7%9F%A5%E8%AF%86%E9%93%BA/

- 版权声明:本作品采用知识共享署名-非商业性使用-禁止演绎 4.0 国际许可协议进行许可,非商业转载请注明出处(作者,原文链接),商业转载请联系作者获得授权。

- 免责声明:本页面内容均来源于站内编辑发布,部分信息来源互联网,并不意味着本站赞同其观点或者证实其内容的真实性,如涉及版权等问题,请立即联系客服进行更改或删除,保证您的合法权益。转载请注明来源,欢迎对文章中的引用来源进行考证,欢迎指出任何有错误或不够清晰的表达。也可以邮件至 sblig@126.com