-- 知识铺

一、前言

随着大语言模型 (LLM) 的蓬勃发展,检索增强生成 (RAG) 技术作为一种将 LLM 与外部知识库结合的有效途径,受到了越来越多的关注。 然而,构建 LLM 应用的真正挑战在于开发者需要根据具体需求进行高度定制化,而现有的 RAG 框架和解决方案却难以满足这一需求。**一些框架追求大而全,功能繁杂且抽象层级过深,开发者难以理解其内部机制,定制化和优化也变得异常困难; 另一方面,一些轻量级工具又过于简单,缺乏生产环境所需的功能和稳健性。**开发者在灵活性和易用性之间难以抉择,构建高质量、定制化的 LLM 应用仍然充满挑战。

LightRAG 应运而生,它是一个基于 PyTorch 的开源库,致力于为开发者提供一个灵活、轻便且面向生产环境的 LLM 应用构建框架,专注于解决现有 RAG 框架的痛点。 LightRAG 秉持着 “Less is More” 的设计理念,将简洁性、灵活性和开发者控制力放在首位, 将控制权交还给开发者, 让他们能够自由地探索各种可能性,打造真正符合自身需求的定制化 LLM 应用。

二、介绍

LightRAG 是一个开源的 PyTorch 库,专为简化检索器-代理-生成器 (RAG) 管道的构建和优化而设计。它提供了一个轻量级、模块化且高度可读的框架,使开发者能够轻松地创建和定制强大的大语言模型应用程序。

LightRAG 框架的核心特点:

- 模块化组件: LightRAG 将 RAG 管道分解为三个核心组件:检索器、代理和生成器。每个组件都设计为独立且可插拔的模块,开发者可以根据需求轻松地替换、修改或扩展。

- 灵活的架构: LightRAG 不依赖于特定的 LLM 提供商或工具,支持开发者自由选择和组合不同的模型、数据库和外部工具,构建高度定制化的 RAG 管道。

- 基于 PyTorch 构建: LightRAG 充分利用了 PyTorch 的灵活性、效率和丰富的生态系统,为开发者提供了强大的深度学习工具和资源。

- 简洁易懂的代码: LightRAG 致力于提供清晰、简洁的代码库, 避免过度抽象, 使开发者能够轻松理解框架的内部机制,并进行必要的调试和定制。

通过 LightRAG,开发者可以摆脱通用框架的束缚,自由地探索 RAG 管道的各种可能性,并快速构建满足特定需求的、面向生产环境的大语言模型应用。

三、为什么选择 LightRAG?

在实际构建基于大语言模型 (LLM) 的生产级应用程序时,我们往往会面临着平衡通用性和定制化需求的挑战。像 LangChain 和 LlamaIndex 的框架虽然功能丰富但过于复杂,而另一些框架虽然轻便但缺乏生产环境所需的稳健性。LightRAG 恰恰就是致力于在这两者之间找到完美的平衡点。

LightRAG 脱颖而出的原因:

- 轻量级 & 高度可控: LightRAG 仅有 1200 行代码, 秉持着“少即是多”的原则, 最大程度减少了抽象层级, 将控制权交还给开发者。 你可以完全掌控代码, 清楚地了解每一行代码的作用, 从而构建高度定制化的 LLM 应用。

- 模块化 & 灵活适应: LightRAG 采用模块化架构, 将 RAG 管道分解为检索器、代理和生成器等独立组件。 你可以轻松地替换、修改或扩展任何组件, 自由组合, 以满足特定的应用需求。LightRAG 不依赖于特定的 LLM 提供商, 可以灵活地适应不同的模型和工具。

- 生产环境就绪 & 高度可靠: LightRAG 不仅仅是一个原型设计工具, 它更专注于满足生产环境的严苛要求。无论你的应用场景多么复杂, LightRAG 都能提供可靠的性能和稳定的输出。

- 清晰易懂 & 便于维护: LightRAG 采用简洁易懂的代码风格, 并提供清晰的文档, 降低了学习和维护成本。 你可以快速上手, 并轻松地进行调试和定制。

LightRAG 是构建轻量级、灵活、可靠且易于维护的 LLM 应用的理想选择。 它将控制权交给你, 让你能够构建真正符合自身需求的定制化解决方案, 同时确保应用在生产环境中的稳定性和可靠性。

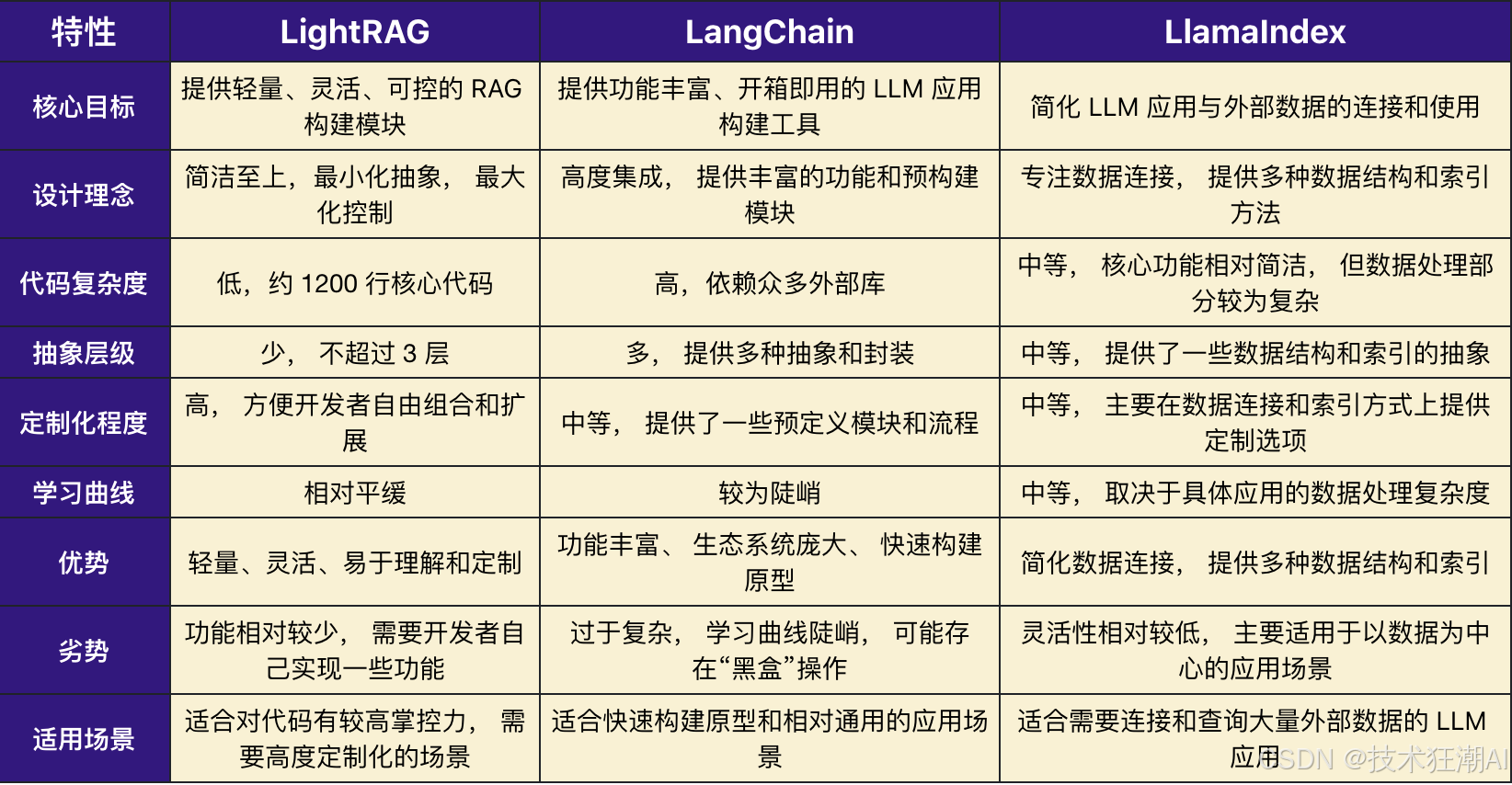

四、LightRAG 与 LangChain & LlamaIndex 对比?

LightRAG、LangChain 和 LlamaIndex 都是用于构建 LLM 应用的开源框架, 但它们的设计理念和侧重点有所不同。

以下是三者的对比:

- LightRAG: 适合追求精细控制、 高度定制和深度优化的开发者。 它提供了一个精简而强大的工具箱, 让你可以自由地构建自己理想中的 LLM 应用。

- LangChain: 适合希望快速构建功能丰富的 LLM 应用的开发者。 它提供了丰富的功能和集成, 让你可以轻松地将各种 LLM 模型、 工具和数据源整合到一起。

- LlamaIndex: 适合需要处理大量非结构化数据, 并希望简化数据连接和查询过程的开发者。 它专注于解决 LLM 应用中的数据挑战, 并提供了强大的数据索引和查询功能。

五、LightRAG 的核心原理

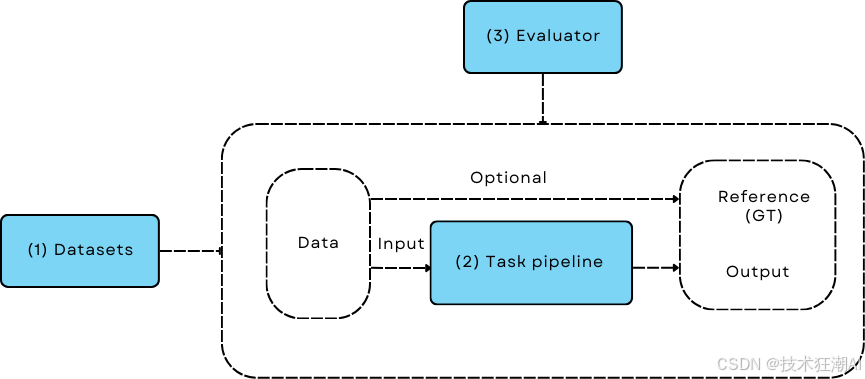

LightRAG 秉持着独特的设计理念,将构建大语言模型 (LLM) 应用视为一种类似于机器学习模型训练/评估的工作流程, 并提供了一套模块化的组件和工具, 帮助开发者高效地构建、 评估和优化 LLM 应用。 它的设计理念和架构为构建高性能、 可定制化的 LLM 应用提供了坚实的基础。 以下这张架构图清晰地展现了 LightRAG 的核心原理以及其关键技术组件。

传统的 LLM 应用开发往往侧重于一次性构建,而 LightRAG 倡导将数据驱动和迭代优化的思想融入 LLM 应用的全生命周期。

- 数据驱动: LightRAG 强调数据在 LLM 应用开发中的核心地位。 从数据集的选择和预处理, 到模型的训练和评估, 每一个环节都离不开数据的支撑。

- 迭代优化: LightRAG 认为 LLM 应用的开发是一个持续迭代优化的过程。 开发者需要根据数据反馈和评估结果, 不断地调整模型参数、 改进 Prompt 设计、 优化检索策略等, 以逐步提升应用的性能和效果。

- 数据集 (Datasets): 高质量的数据集是 LLM 应用成功的基石。 LightRAG 支持多种数据格式, 并提供了灵活的数据加载和预处理工具, 帮助开发者高效地准备训练、 验证和测试数据。 例如, LightRAG 可以方便地处理文本、 代码、 表格等多种数据类型, 并支持自定义数据清洗和特征工程流程。

- 任务管道 (Task Pipeline): 这是 LightRAG 的核心, 它将 LLM 应用分解为一系列可组合的模块化组件, 形成一个完整的数据处理流程。

- 数据预处理: LightRAG 提供了多种数据预处理工具, 例如分词、 词干提取、 停用词去除等, 帮助开发者将原始数据转换为 LLM 可以理解的格式。

- 检索器 (Retriever): LightRAG 的检索器组件负责从外部知识库中检索与用户查询相关的文档或信息片段。 它支持多种检索策略, 例如基于关键词的检索、 基于语义的检索等, 并可以与不同的向量数据库和搜索引擎集成。

- 代理 (Agent): 代理组件是可选的, 它可以与外部环境进行交互, 例如调用 API、 查询数据库或执行特定操作, 从而扩展 LLM 的功能。 LightRAG 的代理组件基于 ReAct 框架实现, 支持开发者使用自然语言来定义代理的行为。

- 生成器 (Generator): 生成器组件接收检索到的信息和用户的查询, 并利用 LLM 生成最终的响应。 LightRAG 为开发者提供了对 Prompt 的高度控制, 支持开发者精细化地设计 Prompt 结构, 以引导 LLM 生成更准确、 更符合预期的结果。

- 评估器 (Evaluator): 评估器用于对 LLM 应用的性能进行评估, 为开发者提供优化方向。 LightRAG 支持多种评估指标, 例如准确率、 召回率、 BLEU 分数等, 同时也支持开发者自定义评估指标。

- 循环迭代: LightRAG 强调迭代优化的重要性。 开发者可以根据评估器的反馈结果, 不断地调整任务管道中的各个组件, 例如修改 Prompt、 优化检索策略、 改进数据预处理流程等, 从而逐步提升 LLM 应用的性能。

六、代码实现

让我们一起探索如何使用 LightRAG 构建大语言模型。

步骤一:安装依赖项

|

|

步骤二:构建 Light RAG 管道

|

|

步骤三:检查提示

|

|

七、总结

LightRAG 使开发人员能够快速有效地构建定制的大语言模型应用程序。其轻量级设计、模块化和强大的基础使其成为不断发展的大语言模型应用程序领域中的宝贵工具。

无论您是在构建聊天机器人、自主代理还是其他基于大语言模型的解决方案,LightRAG 都提供了一个框架,将您的想法变为现实。

参考资料:

[1]. LightRAG:https://github.com/SylphAI-Inc/LightRAG

- 原文作者:知识铺

- 原文链接:https://index.zshipu.com/geek002/post/202410/LightRAG%E9%AB%98%E6%95%88%E6%9E%84%E5%BB%BA%E5%92%8C%E4%BC%98%E5%8C%96%E5%A4%A7%E5%9E%8B%E8%AF%AD%E8%A8%80%E6%A8%A1%E5%9E%8B%E5%BA%94%E7%94%A8%E7%9A%84-PyTorch-%E6%A1%86%E6%9E%B6-CSDN%E5%8D%9A%E5%AE%A2.md--%E7%9F%A5%E8%AF%86%E9%93%BA/

- 版权声明:本作品采用知识共享署名-非商业性使用-禁止演绎 4.0 国际许可协议进行许可,非商业转载请注明出处(作者,原文链接),商业转载请联系作者获得授权。

- 免责声明:本页面内容均来源于站内编辑发布,部分信息来源互联网,并不意味着本站赞同其观点或者证实其内容的真实性,如涉及版权等问题,请立即联系客服进行更改或删除,保证您的合法权益。转载请注明来源,欢迎对文章中的引用来源进行考证,欢迎指出任何有错误或不够清晰的表达。也可以邮件至 sblig@126.com