面向个性化推荐系统的深度学习推荐模型

导读: 今天分享一下 facebook 新发的深度学习推荐系统的论文:

Deep Learning Recommendation Model for Personalization and Recommendation Systems

https://arxiv.org/pdf/1906.00091.pdf

这篇文章概述了当前推荐系统实现的主要思路,提出了一种通用的模型结构 DLRM,与其他常见的 paper 不同,该篇有着浓浓的工业界风格,不仅和其他模型进行效果对比,还讲述了常见的特征如何处理,内在思维逻辑如何,在大规模的现实场景中会面临哪些问题。像大规模稀疏特征如何解决,比如用数据并行与模型并行相结合。以及 CPU 和 GPU 在实践中的性能如何,等等。

有在真实线上实践的同学应该都有过各自的思考,其实我觉得这里边的思路相关同学都是了解的,模型结构也不是壁垒,许多推荐系统问题在实践中更偏向于工程问题。像现今的开源框架都无法支持大规模推荐系统,所以各家其实都有自研的框架和配套设施,去解决海量用户 & 产品等对应的 embeddings,合适的 online training 等等问题

简介

目前个性化推荐有两个主要的方向,现在基本都投奔了深度学习的怀抱中。

the view of recommendation systems

早期系统雇佣专家们来对产品进行分类,用户选择他们喜好的类别并基于他们的偏好进行匹配。此领域后来演变成了协同过滤,推荐基于用户过去的行为,比如对产品的打分。Neighborhood methods将用户和产品分组并用矩阵分解来描述用户和产品的latent factors,获得了成功。

the view of predictive analytics

用统计学模型去分类或预测给定数据的事件概率。预测模型从原来的用简单的linear and logistic regression建模转向了用deep networks。为了处理类别特征,一般采用embeddings,将one-hot或multi-hot vectors转换到抽象空间的dense respresentations。这里的抽象空间其实也就是推荐系统中的latent factors空间。

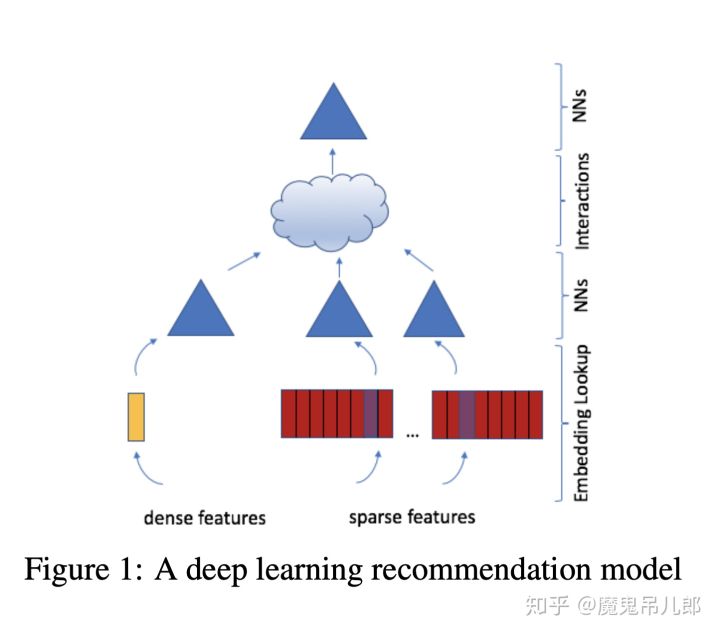

本文结合了上边的两种角度,模型使用embeddings处理稀疏特征,MLP处理稠密特征,然后用统计技术进行显示的特征交叉。最后用另一个MLP来处理交差后的特征,得到事件的概率。我们将这个模型称为RLRM,见图1。 Pytorch&Caffe2开源实现地址

模型设计&结构

Components of DLRM

Embeddings

处理类别特征时,一般使用embedding,实现的时候其实是搞了个lookup table,然后去查对应类别的embedding,所以one-hot vector e_i就相当于是embedding lookup(对位i是1,其他为0),embedding table W \in \mathbb{R}^{m \times d}

embedding也可以被理解为是多个items的带权组合,mulit-hot vector

DLRMs利用embedding tables将类别特征映射到稠密表示。但即使embeddings是有意义的,但我们要如何利用它们进行准确的预测呢? latent factor methods。

Matrix Factorization

回顾推荐问题的典型场景,有一组用户S已经给一些产品进行了评价。我们将产品表示为vector w_i,将用户表示为vector v_j,共n个产品,m个用户。(i,j) S

The matrix factorization approach solves this problem by minimizing

Factoriation Machine

在分类问题中,我们会顶一个预测函数:\phi : \mathbb{R}^{n} \rightarrow T 输入x预测 label y. 我们定义T={+1, -1},+1代表有点击,-1代表每点击,去预测click-through rate。 FM在线性模型上引入了二阶交叉。

FM明显不同于多项式核函数SVM的是,它将分解二阶交叉矩阵到latent factors(or embedding vectors)就像矩阵分解似的,更高效的处理了稀疏数据。通过仅用不同embedding vectors交叉显著减少了二阶交叉的复杂度。转为了线性计算复杂度。

Multilayer Perceptrons

当然,当前许多在机器学习上的成功是源于深度学习的兴起。这里边最基础的模型就是MLP了,一个由FC layers和激活函数组成的预测函数。

这些方法备用来捕获更复杂的interactions。比如在有足够的参数下,MLPs有足够的深度和广度来适应数据到任意精度。各种方法的变种被广泛应用到了各种场景下,包括cv和nlp。有一个特别的case, NCF 被用来做MLPerf benchmark的一部分,它使用MLP来计算矩阵分解中embeddings直接的interaction,而非dot product。

DLRM Architecture

上边描述了推荐系统和预测分析使用的不同模型,现在我们将其组合起来,构建一个state-of-the-art 的个性化模型。 users和products可以用许多的连续特征和类别特征来描述. 类别特征,用同一尺寸的embedding vector表示 连续特征用MLP(bottom or dense MLP)转换为同样长度的稠密向量。

我们按照FM的方式处理稀疏特征,显示地计算不同特征的二阶交叉,可选的将其传给MLPs。将这些dot products与原始的dense features拼接起来,传给另一个MLP(the top or output MLP),最后套个sigmoid函数输出概率。

Comparison with Prior Models

许多基于深度学习的推荐模型使用类似的想法去处理稀疏特征,生成高阶项。 Wide and Deep, Deep and Cross, DeepFm, xDeepFM 都设计了特别的网络去系统性地构建higher-order interactions。这些网络将他们特别的结构和MLP相加,然后传到一个linear layer使用sigmoid函数去输出一个最终概率。 DLRM 模仿因子分解机,以结构化的方式interacts embeddings,通过仅在最终MLP中对embeddings进行dot product产生交叉项来显着降低模型的维数。 我们认为其他网络中发现的二阶以上的高阶交互可能不值得额外的计算/内存消耗。

DLRM与其他网络之间的关键区别在于这些网络如何处理embedded feature vectors 及其交叉项。 特别是,DLRM(和xDeepFM)将每个特征向量解释为表示单个类别的单个unit,而像 Deep and Cross 这样的网络将特征向量中的每个元素视为一个新的unit来产生不同交叉项。 因此, Deep and Cross 不仅会像DLRM中通过点积产生来自不同特征向量的元素之间的交叉项,还会在相同特征向量内的元素之间产生交叉项,从而产生更高的维度。

Parallelism

现在的个性化推荐系统需要大且复杂的模型去充分利用巨大的数据。 DLRMs 尤其包含了非常多的参数,比其他常见的深度学习模型如CNN,RNN,GAN还要大几个数量级。 这导致训练过程可能要到几周甚至更多。为此,要想在实际场景中解决这些问题,就必须有效的并行化这些模型。

如上描述, DLRMs 用耦合的方式处理离散特征和连续特征。其中Embeddings贡献了主要的参数,每个表都要需要很多GB的内存,所以DLRM是内存容量和带宽密集型。embeddings的规模让数据并行变得不可行,因为他需要在每个设备上都复制embeddings。在很多场景下,内存的约束强制让模型的分布必须跨多个设备来满足内存容量的需求。

另一方面,MLP的参数占用内存比较小,但是在计算量上占大头。因此,数据并行适合 MLPs,支持对不同设备上的样本进行并发处理,并且仅在累积更新时需要通信。并行 RLRM 对embeddings用模型并行,对MLP用数据并行,在缓解embeddings的内存瓶颈的同时让MLPs进行前向和反向传播。模型&数据并行的结合是DLRM这样结构和大模型尺寸的一个特别需要。这样组合的并行 Caffe2 和 Pytorch 都不支持,其他流行的深度学习框架也如此,因此我们需要设计一个定制的应用。会在未来的工作中提供详细的性能研究。

在我们的设置里,top MLP和interaction op需要能连接到bottom MLP和所有embeddings。因为模型并行已经将embeddings分散到各个device上,这就需要个性化的all-to-all的通信。在embedding lookup最后这块,每个设备都驻留着一个embedding tables的向量,用于mini-batch中的所有样本,需要沿着min-batch的维度进行拆分并于对应设备通信,如图2所示。

Pytorch 和 Caffe2 都没有提供原生的模型并行,因此我们通过显示的去不同设备上mapping the embedding op来实现。然后使用butterfly shuffle operator实现个性化的全对所有通信,适当地对所得到的embedding vectors进行切片并将它们传送到目标设备。 在当前版本中,这些传输是显式复制,但我们打算使用可用的通信原语(例如all-gather和send-recv)进一步优化它。我们注意到,对于数据并行的MLP,反向传播中的参数更新是用allreduce一起累积的,并以同步方式将参数复制到每个设备上,确保每次迭代前每个设备上的更新参数一致。 在PyTorch中,数据并行性通过nn.DistributedDataParallel和nn.DataParallel模块在每个设备上复制模型并插入allreduce与必要性依赖。 在Caffe2中,我们在梯度更新之前手动插入allreduce。

Data

搞了三个数据集,随机集、人造集和公开数据集.前两个可用于从系统角度试验模型,它允许我们通过动态生成数据,消除对数据存储系统的依赖性来测试不同的硬件属性和瓶颈。 后者让我们对实际数据进行实验并测量模型的准确性。

Random

连续特征用numpy根据均匀分布或者高斯分布来生成。

离散特征我们直接生成embedding matrix以及对应的index

Synthetic

有很多理由让我们定制化的生成类别特征的indices,比如我们用了个特别的数据集,并因为隐私问题不想共享它。那么我们可以通过分布来表达类别特征。这可能有助于替代应用中使用的隐私保护技术,比如federated learning。同样,如果我们想要研究内存行为,我们synthetic trace中原始trace的基本访问位置。

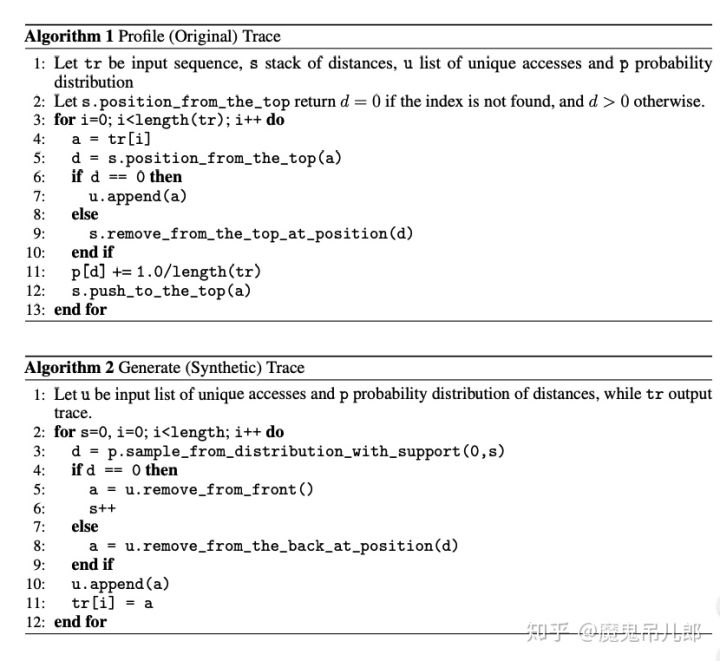

假设我们有所有特征的embedding lookups indices的trace。我们可以记录轨迹中的去重后的访问和重复访问的距离频率(算法.1),生成[14]提的synthetic trace(算法2)。

请注意,我们只能生成到目前为止看到的s次唯一访问,因此s是控制算法2中分布p的支撑集。 给定固定数量的唯一访问,input trace越长将导致在算法1中分配给它们的概率越低,这将导致算法2要更长的时间取得完整分布支撑集。 为了解决这个问题,我们将唯一�

- 原文作者:知识铺

- 原文链接:https://index.zshipu.com/geek/post/%E4%BA%92%E8%81%94%E7%BD%91/%E9%9D%A2%E5%90%91%E4%B8%AA%E6%80%A7%E5%8C%96%E6%8E%A8%E8%8D%90%E7%B3%BB%E7%BB%9F%E7%9A%84%E6%B7%B1%E5%BA%A6%E5%AD%A6%E4%B9%A0%E6%8E%A8%E8%8D%90%E6%A8%A1%E5%9E%8B/

- 版权声明:本作品采用知识共享署名-非商业性使用-禁止演绎 4.0 国际许可协议进行许可,非商业转载请注明出处(作者,原文链接),商业转载请联系作者获得授权。

- 免责声明:本页面内容均来源于站内编辑发布,部分信息来源互联网,并不意味着本站赞同其观点或者证实其内容的真实性,如涉及版权等问题,请立即联系客服进行更改或删除,保证您的合法权益。转载请注明来源,欢迎对文章中的引用来源进行考证,欢迎指出任何有错误或不够清晰的表达。也可以邮件至 sblig@126.com