测试机器学习降维之线性判别模型

原文地址: 谓之小一 公众号

拍摄于无锡古镇

1.LDA简介

线性判别分析(Linear Discriminant Analysis, LDA) 是一种监督学习的降维方法,也就是说数据集的每个样本是有类别输出。和之前介绍的 机器学习降维之主成分分析(PCA) 方法不同,PCA是不考虑样本类别输出的无监督学习方法。LDA的原理简单来说就是将带上标签的数据(点),通过投影的方法,投影到维度更低的空间中,使得投影后的点会形成按类别区分。而我们的目标就是使得投影后的数据, 类间方差最大,类内方差最小。

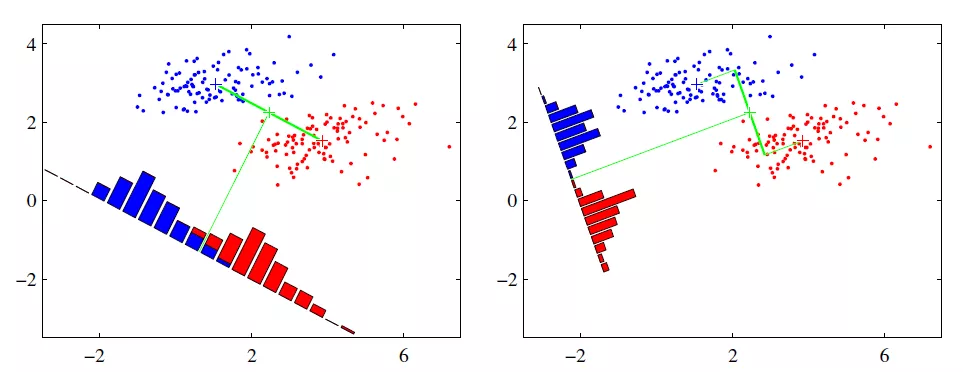

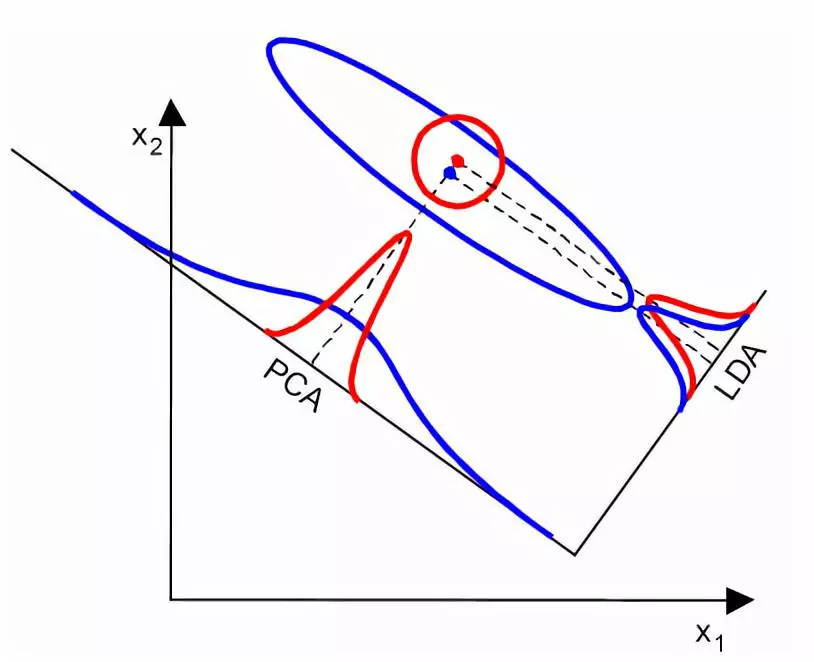

以下图为例,假设有两类数据,分别为红色和蓝色。现在我们希望,将这些数据投影到一维的直线上,让每一种类别数据的投影点尽可能的接近,而红色和蓝色数据中心之间的距离尽可能的大。

从上图的两种投影方式能够看出,右图能够更好的满足我们的目标,即 类间方差最大,类内方差最小。下面我们来看看LDA内部原理,如何达到我们所希望的目标。

2.瑞利商和广义瑞利商

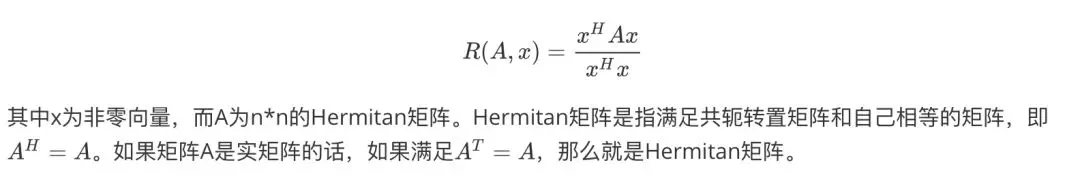

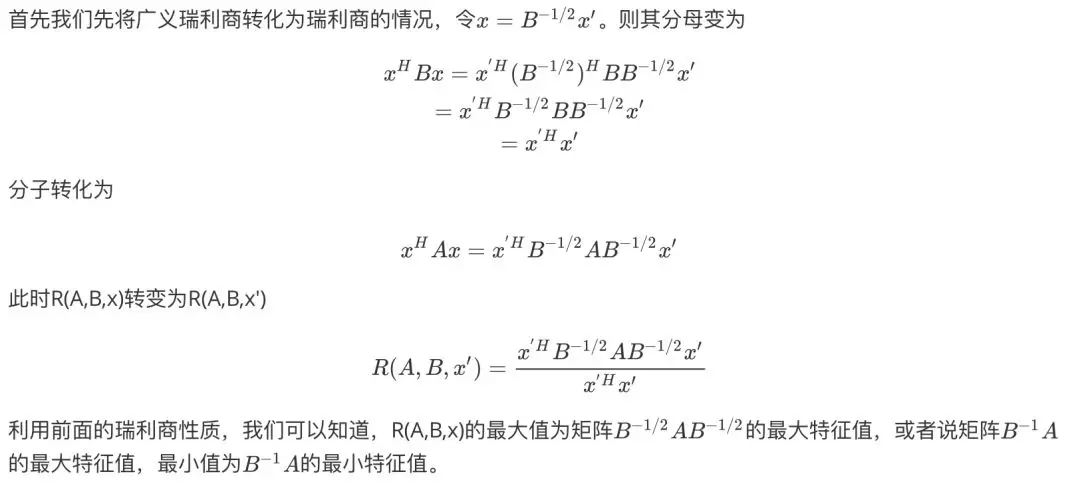

介绍LDA原理之前,我们先了解一些数学知识,即 瑞利商(Rayleigh quotient)与广义瑞利商(genralized Rayleigh quotient)。首先来看看瑞利商的函数R(A,x)

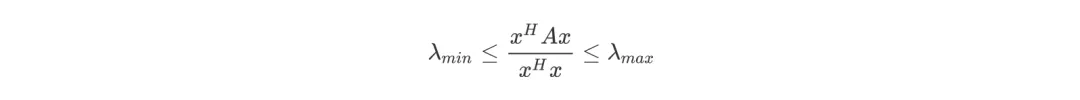

瑞利商R(A,x)有一个非常重要的性质,即它的最大值等于矩阵A的最大特征值,而最小值等于矩阵A的最小特征值,即满足

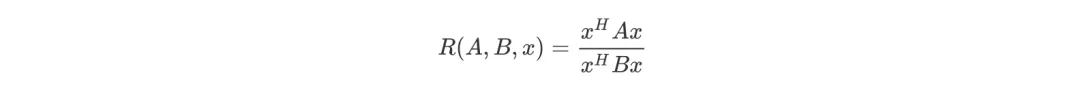

以上就是瑞利商的内容,现在看看广义瑞利商内容,广义瑞利商函数R(A,B,x)

其中x为非零向量,而A,B为n*n的Hermitan矩阵,B是正定矩阵。那么R(A,B,x)的最大值和最小值是什么呢?

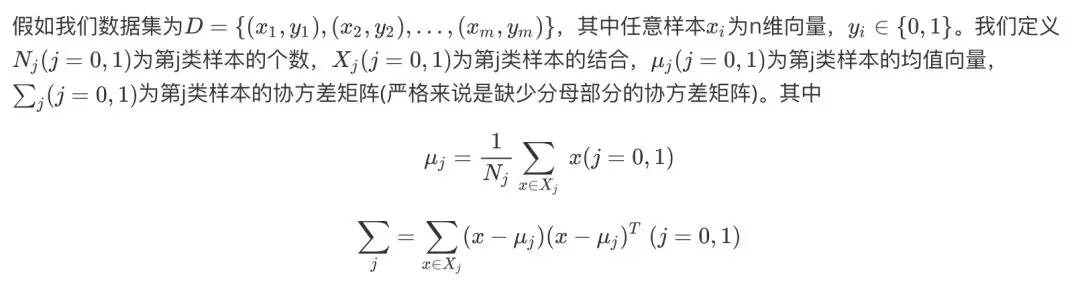

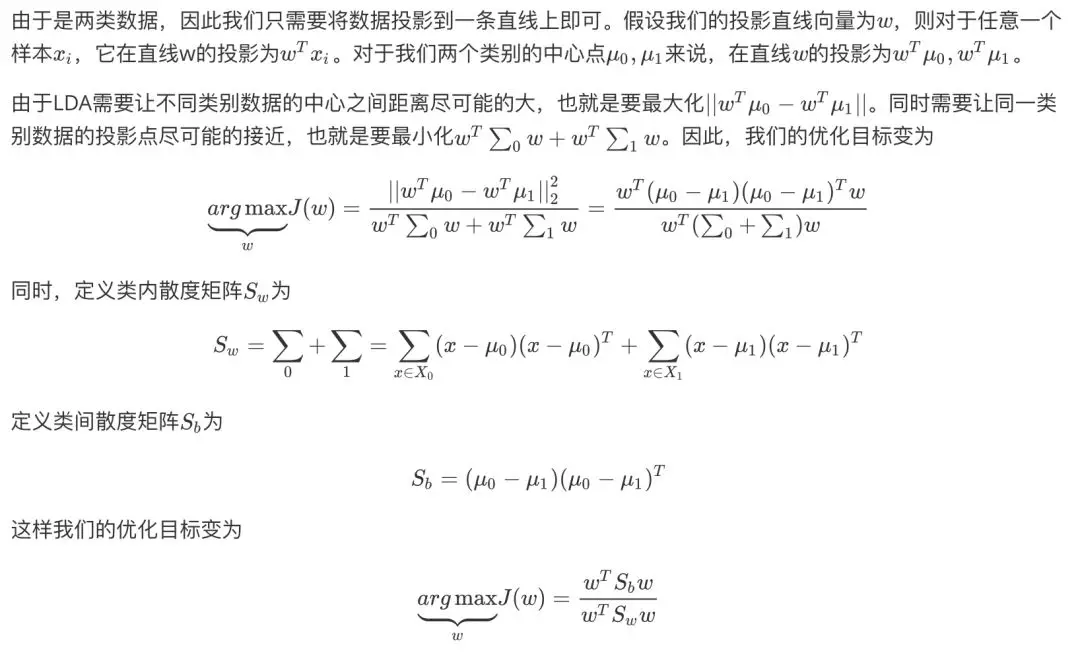

3.二类LDA原理

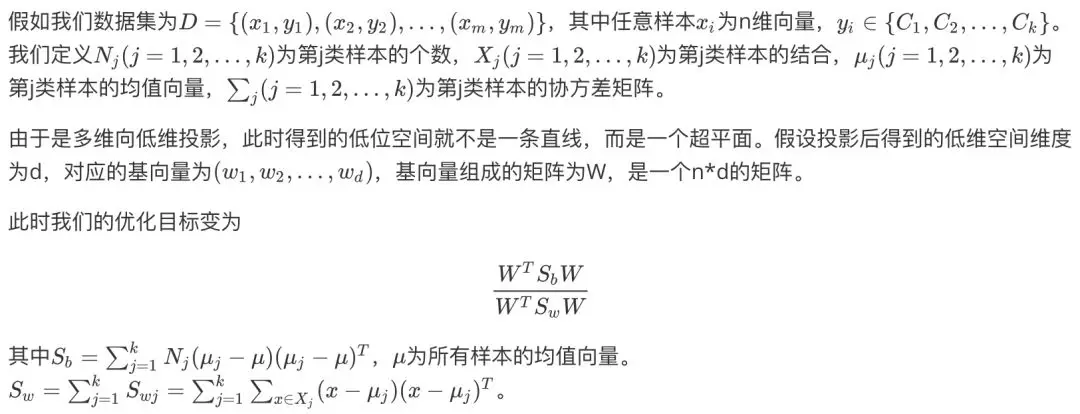

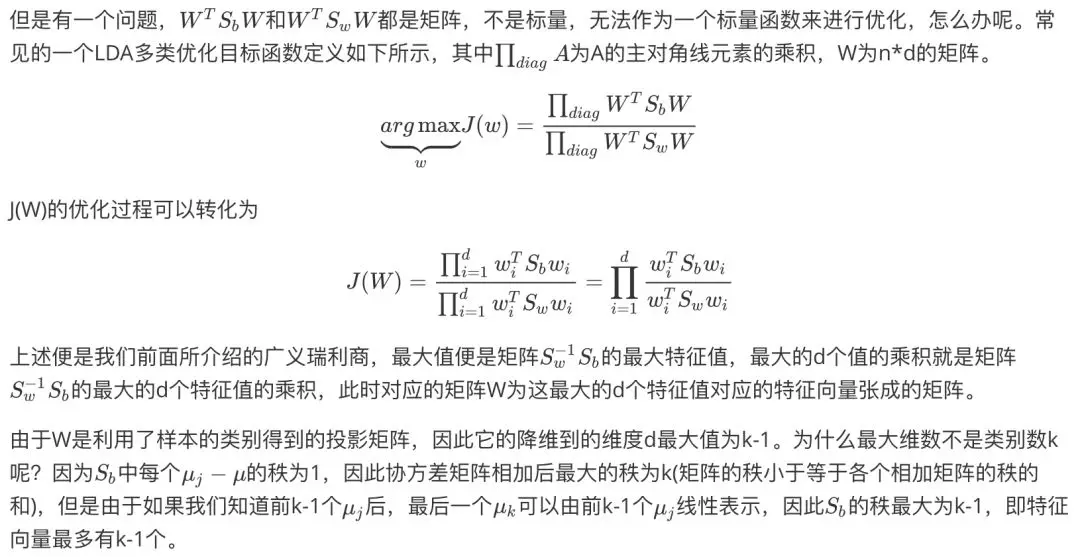

4.多类LDA原理

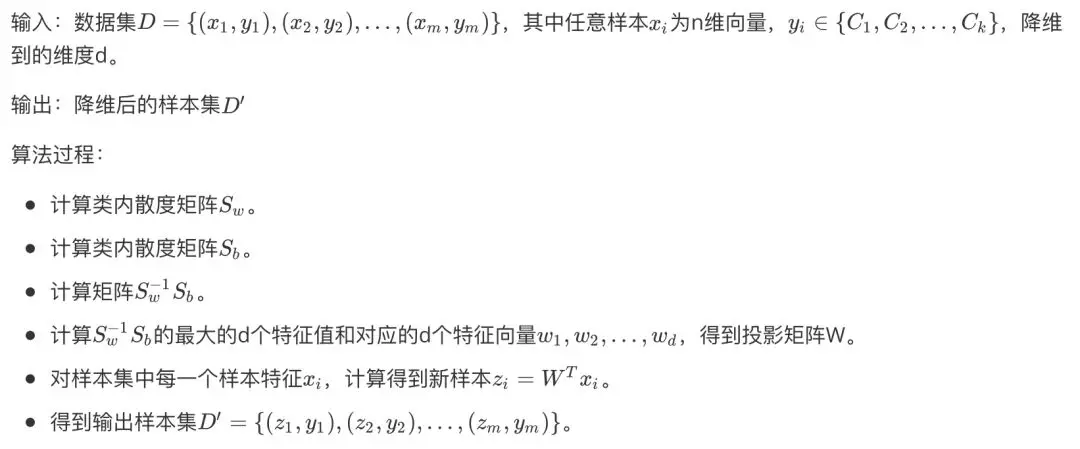

5.LDA算法流程

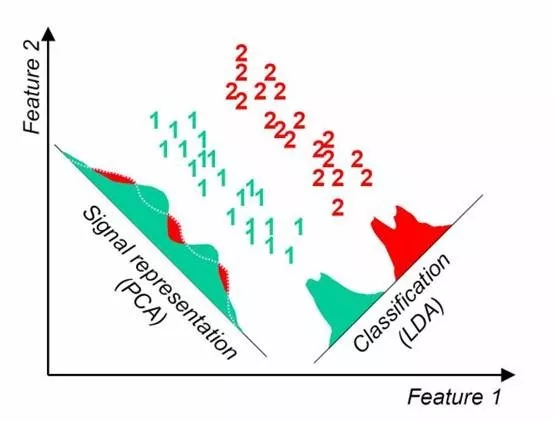

6.LDA vs PCA

LDA和PCA有很多相同点和不同点,我们来对比看看两者的区别。

相同点

-

两者均可对数据进行降维。

-

两者在降维时均使用了矩阵特征分解的思想。

-

两者都假设数据符合高斯分布。

不同点

-

LDA是有监督的降维方法,而PCA是无监督的降维方法。

-

LDA降维最多降到类别数k-1的维数,而PCA无此限制。

-

LDA选择分类性能最好的投影方向,而PCA选择样本点投影具有最大方差的方向。

不同数据情况下,LDA和PCA降维方法各有优劣。例如某些数据情况下LDA比PCA方法更好

某些数据情况下PCA比LDA方法降维更好

7.LDA算法总结

LDA优点

- 在降维过程中可以使用类别的先验知识经验,而PCA这种无监督学习则无法使用类别先验知识。

**LDA�

- 原文作者:知识铺

- 原文链接:https://index.zshipu.com/geek/post/%E4%BA%92%E8%81%94%E7%BD%91/%E6%B5%8B%E8%AF%95%E6%9C%BA%E5%99%A8%E5%AD%A6%E4%B9%A0%E9%99%8D%E7%BB%B4%E4%B9%8B%E7%BA%BF%E6%80%A7%E5%88%A4%E5%88%AB%E6%A8%A1%E5%9E%8B/

- 版权声明:本作品采用知识共享署名-非商业性使用-禁止演绎 4.0 国际许可协议进行许可,非商业转载请注明出处(作者,原文链接),商业转载请联系作者获得授权。

- 免责声明:本页面内容均来源于站内编辑发布,部分信息来源互联网,并不意味着本站赞同其观点或者证实其内容的真实性,如涉及版权等问题,请立即联系客服进行更改或删除,保证您的合法权益。转载请注明来源,欢迎对文章中的引用来源进行考证,欢迎指出任何有错误或不够清晰的表达。也可以邮件至 sblig@126.com