一个更好更快更强的序列标注成分句法分析器

韦阳

华东师范大学 计算机科学与技术硕士在读

原文链接:

Better, Faster, Stronger Sequence Tagging Constituent Parsersgodweiyang.com

为了看懂论文里的策略梯度,又去把强化学习看了一遍。。。

论文地址:

Better, Faster, Stronger Sequence Tagging Constituent Parsersarxiv.org

介绍

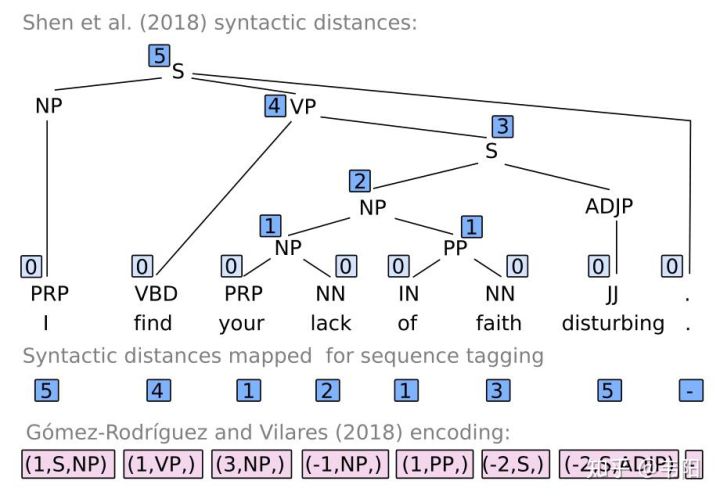

这篇论文主要是在之前的那篇论文

Constituent Parsing as Sequence Labelinggodweiyang.com

基础上解决了如下三个问题:

- 太长的短语预测错误率高。

- 输出空间太大导致label稀疏性。

- 贪心解码导致的错误传播。

本文提出的解决方法分别是:

- 采用融合了相对编码和绝对编码的动态编码。

- 将预测任务分解为多个子任务。

- 采用辅助任务和策略梯度。

三大问题以及解决方法

过长短语预测的高错误率

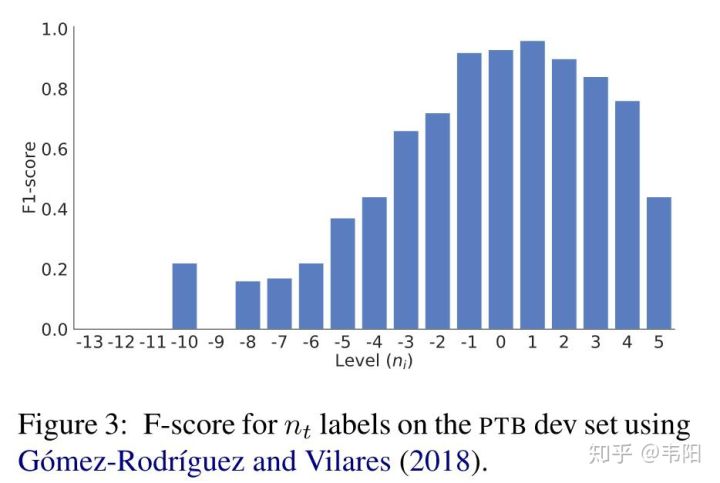

由下面这张图可以看出,当

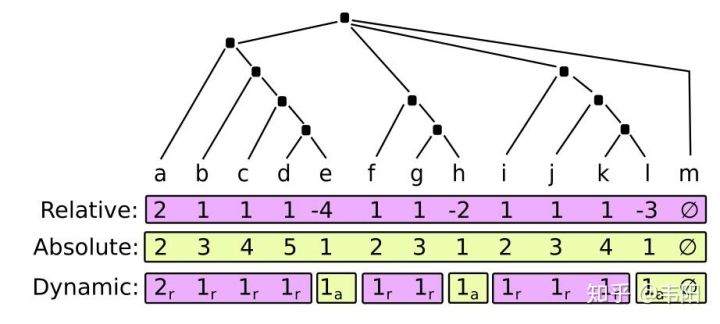

解决方法就是采用动态编码,如下图所示:

第一行是相对值编码,第二行是绝对值编码,之前文章都已经解释过了。第三行是结合了上面两种编码的动态编码,具体取值情况是大多数时候都还采用相对值编码,因为毕竟相对值编码空间比较小,可以适当缓解数据稀疏性。但是当满足如下两种情况的时候,就采用绝对值编码:

- 绝对值

,也就是说CA的个数不能超过3个,这样也是为了降低数据的稀疏性。

- 相对值

,也就是说将上图中准确率比较低的那些负数值全部用绝对值替代了,在句法树中表现为

所在的子树比

低两层以上。

输出空间太大导致label稀疏性

这个问题主要是由于三元组

具体实现上,可以将任务

贪心解码导致的错误传播

这个问题在基于贪心的方法中基本都存在,也就是所谓的一步错步步错,这里主要提出了两种解决方法。

辅助任务 辅助任务主要就是用来帮助主任务学习到一些不太容易学到的信息。这里才用了两个辅助任务,一个是在预测

对于不同的辅助任务,最后将他们的损失求和加到最终的损失函数中去:

策略梯度 这个方法可以从全局的角度来对模型进行优化。假设模型在

定义句法树的概率为每一步决策的概率之积:

所以模型最终就是要最大化如下的奖励:

按照梯度上升的方向更新参数

将

其中

具体实现的时候有好几个小Tips。

第一个就是要将奖励减去一个baseline,这里定义为模型直接根据贪心求得的句法树的F1值:

这么做的目的就是为了让奖励有正有负,不然全部都是正数的话,因为采样不可能全部采样到,可能会导致高概率的样本概率越来越高,而没有采样到的低概率样本可能奖励非常高,却因此概率越来越低。

第二个Tip就是加入熵作为正则项:

目的就是使概率尽量不要太小,不然的话采样数不够的话就有可能造成采样不到小概率的样本。

还有就是给策略加入噪声:

目的同样是加大概率,防止概率太接近于0,当然这个可加可不加。。。

实验结果

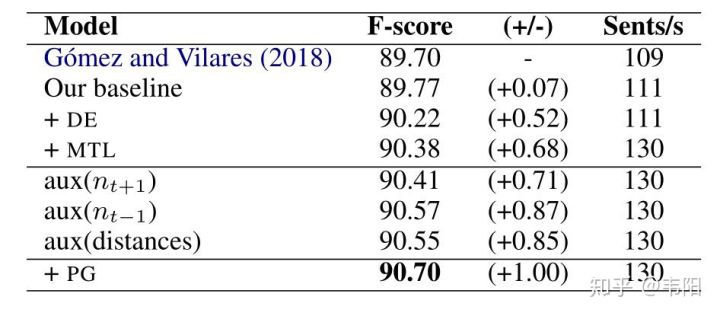

首先测试了不同设置的影响:

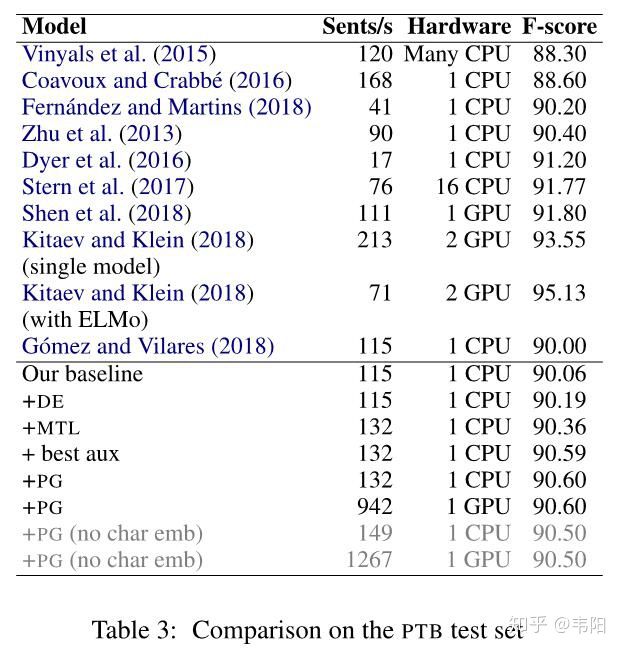

可以看出上面提到的几种方法对性能都有提升,其中采用动态编码、多任务(也就是减少输出空间)、辅助任务(主要是预测前一个

最终模型在测试集上取得了90.6的F1值,虽然不是很高,但比之前的序列标注模型提升还是不少。

最后再来看一下模型在负数预测上的准确率,可以看出有了非常大的提升:

!

- 原文作者:知识铺

- 原文链接:https://index.zshipu.com/geek/post/%E4%BA%92%E8%81%94%E7%BD%91/%E4%B8%80%E4%B8%AA%E6%9B%B4%E5%A5%BD%E6%9B%B4%E5%BF%AB%E6%9B%B4%E5%BC%BA%E7%9A%84%E5%BA%8F%E5%88%97%E6%A0%87%E6%B3%A8%E6%88%90%E5%88%86%E5%8F%A5%E6%B3%95%E5%88%86%E6%9E%90%E5%99%A8/

- 版权声明:本作品采用知识共享署名-非商业性使用-禁止演绎 4.0 国际许可协议进行许可,非商业转载请注明出处(作者,原文链接),商业转载请联系作者获得授权。

- 免责声明:本页面内容均来源于站内编辑发布,部分信息来源互联网,并不意味着本站赞同其观点或者证实其内容的真实性,如涉及版权等问题,请立即联系客服进行更改或删除,保证您的合法权益。转载请注明来源,欢迎对文章中的引用来源进行考证,欢迎指出任何有错误或不够清晰的表达。也可以邮件至 sblig@126.com